Was nach einem halben Jahr KI-Strategie passiert ist...

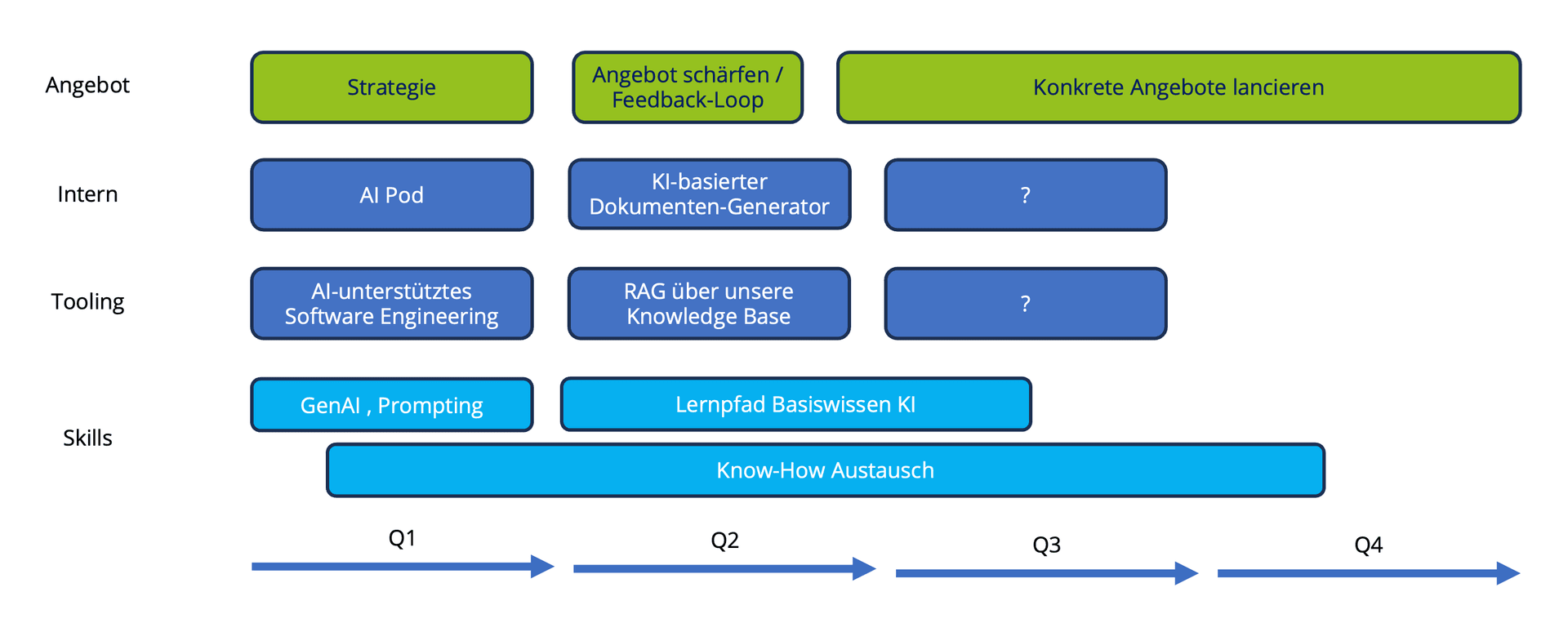

Seit Anfang Jahr beschäftigen wir uns proaktiv und koordiniert mit dem Thema KI. Oder kurz…wir haben einen Pod gegründet, eine einfache KI-Strategie definiert und eine Roadmap gezeichnet, mit welchen Themen wir uns auseinandersetzen möchten. Ziel(e): Mitarbeitende von avega auf den selben Wissensstand bringen und parallel dazu mögliche Use Cases für den technologischen Einsatz und Entwicklung von KI-Tools testen – für internen Einsatz oder auch bei Kund:innen. Im Blog beschreibe ich, was daraus geworden ist (und wir dabei gelernt haben).